¿QUÉ ES EL CONTENIDO DUPLICADO?

El contenido duplicado es aquel texto, imágenes o URLs que aparecen igual o muy parecidas en más de un lugar dentro de tu web o en otros sitios. No hace falta que sea una copia exacta palabra por palabra; si el contenido cambia ligeramente, Google también puede considerarlo duplicado. Esto incluye fragmentos de texto que se repiten en distintas secciones de tu web, como descripciones de productos, bloques de contenido en varias categorías, etiquetas comunes o incluso versiones impresas o traducidas de una misma página que no están bien gestionadas.

El problema surge cuando los motores de búsqueda no saben cuál es la versión «principal» o más relevante, y esto puede afectar la indexación o el posicionamiento de todas las versiones involucradas. En casos graves, puede dar lugar a que tu web pierda visibilidad. Tener contenido duplicado es como tener varios carteles iguales en distintas calles: confunde y no aporta valor adicional. Lo ideal es que cada página sea única, original y centrada en aportar información específica.

PRINCIPALES TIPOS DE CONTENIDO DUPLICADO

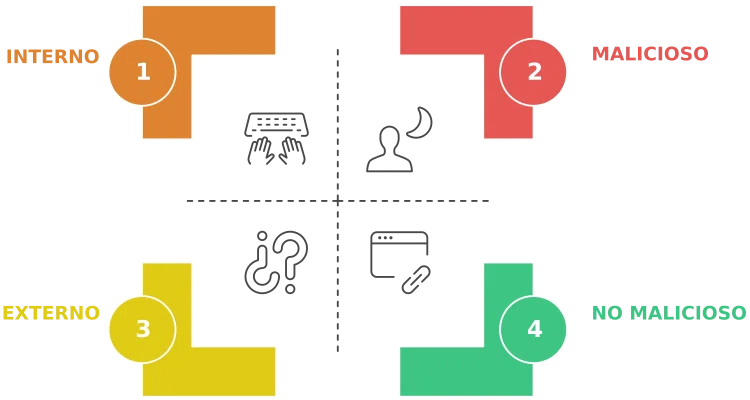

Antes de entrar en soluciones, conviene entender los distintos tipos de contenido duplicado que puedes encontrar. No todo el contenido duplicado es igual ni se produce por las mismas razones. A veces es un descuido técnico, otras una mala práctica editorial o incluso un intento malicioso de manipular los resultados de búsqueda. Reconocer cada tipo te ayudará a diagnosticar y resolver el problema con mayor precisión.

- Interno. Se produce cuando el mismo contenido aparece en varias URLs dentro de tu propia web. Por ejemplo, puede pasar con fichas de productos similares, etiquetas mal gestionadas, versiones imprimibles de las páginas o contenidos repetidos en categorías distintas. Este tipo de duplicado es muy común y suele estar relacionado con la estructura y configuración del CMS.

- Externo. Ocurre cuando el mismo contenido aparece tanto en tu sitio como en páginas externas. A menudo se trata de plagio directo, aunque también puede suceder al compartir contenido con terceros (como publicaciones invitadas o sindicación) sin aplicar las etiquetas correctas. Este tipo es especialmente delicado, ya que puede hacer que tu versión original no sea la que aparece primero en Google.

- No Malicioso. Suele darse por descuidos técnicos. Ejemplos comunes incluyen las versiones con y sin «www», URLs con parámetros que generan contenido idéntico o publicaciones sindicadas que no utilizan la etiqueta canonical. Aunque no hay intención de manipular, sigue afectando negativamente al posicionamiento si no se gestiona adecuadamente.

- Malicioso. Este es el caso más grave. Se trata de contenido duplicado creado con la intención deliberada de engañar a los motores de búsqueda, ya sea para ocupar más posiciones en los resultados o para dañar a la competencia. Google detecta este tipo de prácticas como spamdexing y puede penalizar severamente a los sitios que las utilicen.

EL PROBLEMA DEL CONTENIDO DUPLICADO

Tener contenido duplicado puede generar múltiples complicaciones para tu sitio web, tanto a nivel técnico como de posicionamiento. Desde la perspectiva del SEO, Google puede tener dificultades para saber qué versión mostrar en los resultados, lo que afecta directamente a la visibilidad de tu contenido. Además, si varias páginas contienen la misma información, la autoridad de tu dominio se diluye, los enlaces entrantes se reparten entre varias versiones y tu web pierde fuerza en el ranking. A nivel de experiencia de usuario, mostrar el mismo contenido en distintas partes del sitio o ver páginas idénticas en los resultados de búsqueda genera confusión, lo que reduce el porcentaje de clics y afecta negativamente a la percepción de calidad. Finalmente, aunque no todo contenido duplicado conlleva una penalización directa, si Google interpreta que hay intención de manipular el algoritmo, puede tomar medidas drásticas como desindexar páginas o bajar su posición de forma significativa.

DETECTAR CONTENIDO DUPLICADO

Detectar contenido duplicado no es tan complicado como parece, pero sí requiere atención y una revisión constante. Con las herramientas adecuadas, puedes identificar tanto duplicidades internas como externas antes de que afecten tu posicionamiento. A continuación, te explico cómo hacerlo paso a paso.

HERRAMIENTAS MANUALES

Las herramientas manuales para detectar contenido duplicado son ideales si estás comenzando o tienes un sitio web pequeño. La primera de ellas es Google Search Console, una plataforma gratuita que te permite ver cuáles de tus páginas están indexadas, identificar problemas relacionados con contenido duplicado y recibir notificaciones sobre errores de cobertura. Además, puedes inspeccionar URLs individualmente para ver si Google detecta problemas de duplicidad. Otra técnica sencilla es usar el comando «site:tuweb.com «frase exacta»» directamente en Google. Este truco consiste en copiar una frase concreta de una página y buscarla entre comillas, lo que te permite ver si aparece en otras páginas de tu propio sitio o incluso en webs externas. Aunque no es una solución automática ni escalable, esta búsqueda te da pistas rápidas y efectivas. Para proyectos pequeños, estas herramientas manuales son más que suficientes para empezar a tomar el control del contenido duplicado antes de que afecte tu posicionamiento.

HERRAMIENTAS AUTOMÁTICAS

Cuando tu sitio web empieza a crecer o manejas varias páginas, las herramientas automáticas se vuelven imprescindibles para detectar contenido duplicado de forma eficiente.

Plataformas como SEMrush y Ahrefs permiten rastrear tu sitio en busca de duplicidades internas y comparar tu contenido con millones de páginas públicas para identificar posibles plagios externos. Estas herramientas también analizan encabezados, metadescripciones, contenido textual y estructuras de URL que puedan estar generando conflictos.

Por su parte, Screaming Frog es una opción muy potente para auditorías técnicas; permite identificar títulos repetidos, meta descripciones duplicadas y páginas con contenido idéntico o muy similar. Además, puedes exportar los datos para analizarlos con mayor profundidad.

Si lo que te interesa es detectar plagios fuera de tu web, Copyscape es una solución muy útil: escanea la red en busca de coincidencias exactas con tu contenido. Aunque muchas de estas herramientas tienen versiones de pago, su valor a largo plazo compensa sobradamente el coste.

| HERRAMIENTA | INTERNO | EXTERNO | GRATIS HASTA |

| Google Search Console | Siempre Gratis | ||

| Screaming Frog | Hasta 500 URLs | ||

| SEMrush / Ahrefs | Planes de Pago | ||

| Copyscape | Gratis con Límites |

¿cómo solucionarlo?

Detectar el problema es solo la mitad del trabajo. Ahora toca ponerse manos a la obra. Por suerte, existen múltiples formas de resolver el contenido duplicado, y muchas de ellas están al alcance de cualquier usuario, sin necesidad de conocimientos técnicos avanzados. Aquí te presento las soluciones más eficaces, explicadas paso a paso.

CANONICALS

La etiqueta canonical es una forma de decirle a Google cuál es la versión preferida de una página cuando hay contenido similar o idéntico en varias URLs. Se añade en el código HTML de la página y actúa como una indicación clara para que los motores de búsqueda entiendan cuál debe considerarse como la fuente original. Esto es especialmente útil cuando se tienen versiones para impresión, parámetros en la URL o contenido replicado por razones técnicas. Aplicar bien esta etiqueta ayuda a consolidar la autoridad en una sola versión y a evitar la dispersión del posicionamiento.

REDIRECCIONES 301

Las redirecciones 301 son una solución ideal cuando quieres eliminar una URL duplicada de forma definitiva y pasar todo su valor SEO a otra página. Se utilizan para indicar que una página ha sido movida de manera permanente, y son especialmente útiles en casos donde se han creado múltiples versiones de una misma página o se han cambiado estructuras de URL. Implementarlas correctamente ayuda a evitar errores 404, mejora la experiencia de usuario y concentra toda la autoridad en la URL principal que deseas posicionar.

META ROBOTS NOINDEX

El uso de la etiqueta meta robots con el valor «noindex» sirve para evitar que ciertas páginas aparezcan en los resultados de búsqueda. Es muy útil para páginas que no aportan valor único, como filtros, resultados de búsqueda interna o versiones que no deseas indexar. Al indicar a Google que no las indexe, reduces el riesgo de duplicación y ayudas al buscador a centrarse en el contenido verdaderamente relevante. No afecta a la navegación del usuario, pero sí optimiza el rastreo del sitio.

ROBOTS.TXT

El archivo robots.txt permite controlar qué partes de tu web pueden ser rastreadas por los motores de búsqueda. Es especialmente útil cuando tu sitio genera muchas URLs dinámicas con parámetros que resultan en contenido duplicado. Al bloquear estas rutas desde el archivo robots.txt, impides que Google las rastree, aunque eso no significa necesariamente que no se indexen. Por eso, se recomienda combinar esta técnica con otras como el noindex o canonical para asegurar un control más completo.

REESCRITURA

Reescribir el contenido duplicado es una de las formas más efectivas de solucionarlo cuando se trata de texto repetido. El objetivo es aportar valor añadido, enriquecer la información existente y evitar que varias páginas digan lo mismo con otras palabras. Puedes añadir ejemplos, opiniones, estudios de caso o explicaciones más detalladas para diferenciar el contenido. Esta técnica es especialmente útil en e-commerce, donde muchas fichas de producto terminan siendo prácticamente iguales. Con un poco de esfuerzo, puedes transformar contenido redundante en una ventaja competitiva.

TÍTULOS Y METADESCRIPCIONES ÚNICAS

Tener títulos y metadescripciones únicos para cada página es fundamental para el SEO. Estos elementos ayudan a Google a entender de qué trata cada URL y a mostrar información relevante en los resultados de búsqueda. Si repites títulos o descripciones, confundes al buscador y reduces tus posibilidades de destacar. Además, un título bien redactado y una descripción atractiva pueden mejorar significativamente el CTR. No se trata solo de evitar duplicados, sino de aprovechar cada espacio para atraer al usuario con mensajes claros y diferenciados.

CONTROL EN CMS

Muchos problemas de contenido duplicado nacen de una mala configuración del CMS. Plantillas que repiten los mismos textos, categorías mal estructuradas, etiquetas innecesarias o contenidos generados automáticamente pueden generar múltiples páginas con contenido idéntico. Para evitarlo, revisa con frecuencia cómo tu CMS genera URLs, etiquetas y archivos. Usa plugins o extensiones que permitan mayor control sobre la indexación y asegúrate de personalizar cada sección con contenido único. Una buena estructura interna es clave para evitar duplicidades desde el origen.

ELIMINAR PLAGIOS EXTERNOS

Cuando detectas que otros sitios han copiado tu contenido sin permiso, lo primero que debes hacer es contactar al responsable del sitio y solicitar la eliminación o, al menos, la atribución correcta mediante un enlace. Si no recibes respuesta, puedes presentar una solicitud de retirada por derechos de autor a través de Google (DMCA). También puedes usar herramientas como Copyscape para encontrar estas copias y actuar a tiempo. Proteger tu contenido original es clave no solo por reputación, sino también para evitar que otra web termine posicionando por tu trabajo.

MONITOREO CONSTANTE

Prevenir es mejor que curar, y por eso es fundamental establecer un sistema de monitoreo regular. Configura alertas semanales con herramientas como Copyscape, Google Alerts o SEMrush para identificar rápidamente cualquier duplicado nuevo. Esta vigilancia activa te permite actuar con rapidez antes de que el contenido duplicado afecte tu posicionamiento o autoridad. Incluir auditorías de contenido en tu calendario de mantenimiento también es una buena práctica para detectar duplicidades internas, errores en metadatos o problemas generados por actualizaciones en tu CMS.

FLUJO DIARIO RECOMENDADO

Tener un proceso claro y constante es clave para mantener tu web libre de contenido duplicado. No se trata solo de detectar y corregir problemas puntuales, sino de establecer un hábito de revisión y mantenimiento. A continuación, te propongo una rutina sencilla que puedes seguir semana a semana para mantener tu SEO en forma.

Rastrea con Screaming Frog + GSC. Empieza tu análisis con estas herramientas para identificar páginas problemáticas, duplicados de títulos y contenido, o errores de indexación. Ambas te ofrecen una visión clara de cómo ve Google tu sitio.

Detecta URLs duplicadas. Filtra los resultados para encontrar páginas con contenido idéntico o muy similar. Pon especial atención a parámetros en la URL, versiones www/no-www o HTTP/HTTPS.

Usa canonicals, noindex o redirecciones. Aplica la solución más adecuada según el tipo de duplicado detectado. Así canalizas el valor SEO hacia la página correcta y evitas confusiones.

Reescribe contenido si es necesario. Si el contenido duplicado es valioso pero repetido, revísalo y modifícalo para hacerlo único. Puedes añadir ejemplos, casos reales o profundizar en detalles concretos.

Revisa plagios externos y actúa. Usa herramientas como Copyscape para detectar copias de tu contenido. Si encuentras algún caso, contacta con los responsables o inicia un proceso DMCA para proteger tu trabajo.

BUENAS PRÁCTICAS

Para mantener tu sitio limpio de contenido duplicado a largo plazo, conviene aplicar una serie de buenas prácticas de forma sistemática. No se trata solo de corregir errores pasados, sino de prevenir que se repitan en el futuro. Estas recomendaciones son simples pero efectivas y te ahorrarán muchos dolores de cabeza.

Configura bien www/no-www y HTTPS. Asegúrate de que tu sitio solo se muestra bajo una única versión, es decir, que todas las versiones redirigen correctamente a una sola. Esto evita que Google vea tu contenido repetido en diferentes protocolos o subdominios.

Usa canonicals en páginas similares. Siempre que tengas contenido que se repite por motivos técnicos o de navegación, como filtros o versiones alternativas, añade una etiqueta canonical apuntando a la versión principal. Así indicas claramente cuál es la página preferida para indexar.

Evita indexar etiquetas o feeds. En muchos CMS, como WordPress, las etiquetas y los feeds generan páginas automáticas que no aportan valor real. Añadir noindex a estas páginas evita que se indexen contenidos repetidos o poco relevantes.

Verifica metadatos únicos. Cada página debe tener su propio título y descripción. No repitas estos campos, ya que son clave para destacar en los resultados de búsqueda y mejorar el CTR. Un buen metadato es casi tan importante como el contenido.

Evita contenido automatizado y repetitivo. Generar contenido masivo con herramientas automáticas puede ser tentador, pero suele derivar en textos muy similares entre sí. Invierte tiempo en redactar con intención, orientado al usuario y con valor añadido. Google premia lo auténtico y útil.

CONCLUSIÓN

El contenido duplicado no siempre implica una penalización directa, pero sí representa un obstáculo real para el posicionamiento de tu web.

Si bien Google ha mejorado en la gestión de estos casos, confiarse puede salir caro. Ignorar las duplicidades puede traducirse en una pérdida de tráfico, reducción de la autoridad de tus páginas y menor visibilidad frente a la competencia. Por eso, lo mejor es adoptar una actitud proactiva: revisar tu contenido con frecuencia, implementar soluciones técnicas como etiquetas canonicals o redirecciones, y generar textos originales y útiles para tus usuarios.

No olvides que una web limpia y bien estructurada habla bien de tu marca y mejora la experiencia del visitante. Las cosas claras y el chocolate espeso: más vale prevenir con contenido único, que lamentar por no haberle prestado atención a tiempo.

GUÍA PARA AUDITORÍA SEO BÁSICA EN WORDPRESS

«Obtén gratis la guía paso a paso para detectar errores SEO en tu WordPress y mejora tu posicionamiento en Google»

Quiero mi GuíaÓscar Bages

¡Hola! Soy Óscar Bages, un apasionado del mundo digital, especializado en Posicionamiento SEO y en la creación de Tiendas Online. Con más de una década de experiencia, me gustaría transmitir parte de mi conocimiento, para todo aquél que quiera aprovecharlo. Nos vamos viendo...