¿QUÉ ES UN ROBOTS.TXT Y CÓMO CONFIGURARLO CORRECTAMENTE?

Un archivo robots.txt es un fichero de texto ubicado en la raíz de tu web (por ejemplo https://tu-sitio.com/robots.txt). Su función principal es indicar a los bots de los motores de búsqueda (como Googlebot, Bingbot, entre otros) qué partes de tu sitio web pueden rastrear y cuáles no. En otras palabras, les das instrucciones sobre cómo comportarse cuando visitan tu sitio. Esta herramienta forma parte del estándar de exclusión de robots y es una de las primeras cosas que un bot consulta al llegar a una web.

Este archivo no solo ayuda a mejorar la eficiencia del rastreo, sino que también permite controlar el acceso a contenido que no deseas que aparezca en los resultados de búsqueda, como páginas duplicadas, zonas privadas o recursos no relevantes para SEO (como archivos PDF o carpetas internas).

Aunque el archivo robots.txt es muy útil, no debe confundirse con una herramienta de seguridad, ya que cualquiera puede acceder a él y algunos bots maliciosos pueden ignorarlo completamente.

¿PARA QUÉ SIRVE UN ROBOTS.TXT?

El archivo robots.txt tiene múltiples utilidades que van más allá de simplemente bloquear el acceso a ciertas partes de tu sitio. Es una herramienta estratégica que te permite controlar el comportamiento de los rastreadores y optimizar la forma en que los motores de búsqueda interactúan con tu web. A continuación, te explico en detalle los principales usos:

- Controlar el tráfico del bot. Puedes reducir la carga sobre tu servidor impidiendo que los bots accedan a recursos innecesarios. Esto mejora el rendimiento general de tu sitio, especialmente si recibes muchas visitas o si tu servidor tiene recursos limitados. Al bloquear rutas poco relevantes, priorizas el rastreo de tus páginas más valiosas.

- Optimizar el presupuesto de rastreo. Google y otros motores no rastrean tu sitio indefinidamente. Tienen un presupuesto de rastreo asignado, y si se desperdicia en páginas sin valor, otras importantes podrían quedar fuera. El robots.txt ayuda a dirigir ese presupuesto de forma inteligente, indicando qué evitar.

- Evitar duplicidades. Muchas webs tienen versiones alternativas de la misma página (con parámetros, por ejemplo). Al bloquear esas versiones duplicadas, evitas confundir a Google y aumentas las probabilidades de posicionar la versión correcta. Esto es vital para evitar penalizaciones por contenido duplicado.

- Excluir archivos multimedia. Documentos PDF, imágenes o scripts que no necesitas indexar pueden ser excluidos. Esto no solo ahorra recursos, sino que también centra la atención de Google en el contenido realmente relevante para el posicionamiento de tu sitio.

- No es una medida de seguridad. Aunque puedas bloquear secciones privadas o sensibles, cualquier persona puede acceder al robots.txt y ver qué estás tratando de ocultar. Además, los bots maliciosos suelen ignorar estas reglas. Por eso, nunca uses robots.txt como única medida de protección: combínalo con autenticación, contraseñas o firewalls.

ESTRUCTURA DE UN ARCHIVO ROBOTS.TXT

El archivo robots.txt está formado por un conjunto de reglas que indican a los bots de búsqueda cómo deben interactuar con tu sitio. Cada regla se define en bloques que comienzan por especificar a qué bot se aplica y qué partes del sitio puede o no puede rastrear. Aunque su sintaxis es sencilla, una mala configuración puede tener consecuencias negativas para el SEO. Vamos a ver cada parte clave:

- User-agent. Esta línea indica a qué bot se dirige el grupo de reglas. Por ejemplo, User-agent: Googlebot se refiere específicamente al bot de Google, mientras que User-agent: * aplica las reglas a todos los bots. Siempre debe ser la primera línea de un bloque de reglas.

- Disallow. Indica qué rutas no deben ser rastreadas. Por ejemplo, Disallow: /privado/ le dice a los bots que no accedan a esa carpeta. Si no se desea bloquear nada, se puede dejar en blanco: Disallow:.

- Allow (opcional). Permite el rastreo de rutas específicas dentro de un área bloqueada por Disallow. Es muy útil para liberar el acceso a archivos concretos dentro de directorios bloqueados. Por ejemplo, Allow: /privado/publico.html.

- Sitemap (opcional). Puedes añadir la URL de tu sitemap para que los bots accedan directamente a un mapa completo de tu sitio. Esto mejora la indexación y complementa la función del robots.txt.

Ejemplo básico

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://tu-sitio.com/sitemap.xmlEste ejemplo indica a todos los bots que no accedan a /wp-admin/, excepto al archivo admin-ajax.php. Además, proporciona el sitemap para facilitar el rastreo e indexación de la web.

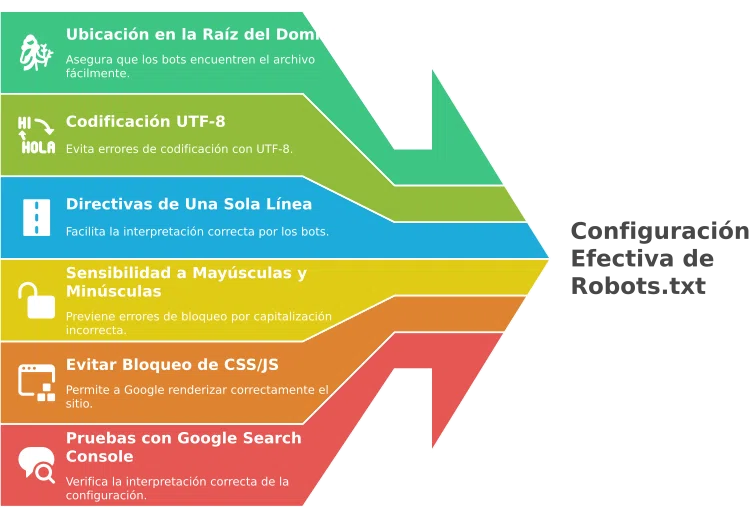

BUENAS PRÁCTICAS PARA CONFIGURAR TU ROBOTS.TXT

Aunque el archivo robots.txt puede parecer simple, configurarlo correctamente requiere atención al detalle. Pequeños errores pueden impedir que tus páginas más importantes se indexen o dejar expuestas secciones que preferirías ocultar. Estas buenas prácticas te ayudarán a sacarle el máximo provecho y evitar fallos comunes:

- Colócalo en la raíz de tu dominio (https://tu-sitio.com/robots.txt). Si no lo colocas en la raíz, los bots no lo encontrarán y lo ignorarán por completo.

- Asegúrate de usar UTF-8 sin formato de Word ni caracteres especiales. Utiliza editores de texto plano para evitar codificaciones incompatibles que puedan invalidar el archivo.

- Una sola línea por directiva. Cada instrucción debe ocupar su propia línea para garantizar que los bots la interpreten correctamente. Combinar reglas puede provocar errores inesperados.

- Cuidado con la sintaxis, los paths distinguen entre mayúsculas y minúsculas, por lo que /Privado/ no es lo mismo que /privado/. Un simple error de capitalización puede dejar contenido expuesto o mal bloqueado.

- Evita bloquear CSS/JS si afectan la renderización del contenido. Google necesita acceder a estos recursos para entender correctamente la estructura y funcionalidad de tu sitio.

- Testea con Google Search Console cada cambio. Utiliza la herramienta «Probador de robots.txt» para asegurarte de que tu configuración se interpreta como esperas. Es mejor prevenir que lamentar.

- No relies en “noindex” dentro del robots.txt, aunque fue admitido informalmente durante un tiempo, Google ya no lo respeta. Para evitar que una página se indexe, usa la etiqueta meta noindex directamente en el HTML.

CREACIÓN Y SUBIDA DEL ARCHIVO ROBOTS.TXT

Crear y subir un archivo robots.txt es una tarea sencilla, pero que debe hacerse con precisión para garantizar su correcto funcionamiento. A continuación, te explico paso a paso cómo hacerlo correctamente y sin errores técnicos.

1º _ ABRE UN EDITOR DE TEXTO

Utiliza programas como Notepad, TextEdit (en modo texto plano), o editores de código como VS Code o Sublime Text. Evita procesadores de texto como Word que puedan introducir formatos invisibles.

2º _ ESCRIBE TU CONFIGURACIÓN BÁSICA

Añade las directivas necesarias según tus objetivos. Puedes empezar con un bloque simple como User-agent: * y Disallow: para permitir el acceso total o ajustar según tus necesidades.

3º _ GUARDA EL ARCHIVO CON CODIFICACIÓN UTF-8

Asegúrate de que el archivo no contenga caracteres extraños ni formatos ocultos. El nombre del archivo debe ser exactamente robots.txt, todo en minúsculas.

4º _ SÚBELO AL DIRECTORIO RAÍZ

Utiliza un cliente FTP (como FileZilla) o el panel de tu proveedor de hosting para colocar el archivo en la raíz del dominio principal. Por ejemplo, debe estar disponible en https://tu-dominio.com/robots.txt.

5º _ CONFIRMA QUE SEA ACCESIBLE PÚBLICAMENTE

Una vez subido, abre la URL en tu navegador. Si puedes visualizarlo directamente, los bots también podrán acceder a él. Además, puedes validarlo desde Google Search Console para comprobar que no hay errores.

EJEMPLOS TÍPICOS

El archivo robots.txt puede adaptarse a muchas necesidades según el tipo de sitio web y los objetivos de indexación. A continuación, verás varios ejemplos de configuraciones comunes que te servirán de base para crear o ajustar el tuyo. Recuerda que estos son solo modelos y deberías personalizarlos según el contenido y estructura de tu web.

# Permitir todo para todos los bots

User-agent: *

Disallow:# Bloquear todo

User-agent: *

Disallow: /# Bloquear un bot específico

User-agent: BadBot

Disallow: /# Permitir sólo un bot y bloquear el resto

User-agent: *

Disallow: /

User-agent: Googlebot

Disallow:# Bloquear extensiones específicas

User-agent: *

Disallow: /*.php$

Disallow: /*.js$# Bloquear extensiones específicas

User-agent: *

Disallow: /*.php$

Disallow: /*.js$# Bloquear una carpeta específica pero permitir un archivo dentro de ella

User-agent: *

Disallow: /blog/

Allow: /blog/post-destacado.html# Bloquear parámetros de URL que generan contenido duplicado

User-agent: *

Disallow: /*?ordenar=

Disallow: /*?filtro=# Bloquear resultados internos de búsqueda del sitio

User-agent: *

Disallow: /busqueda/# Permitir solo el acceso a imágenes en una carpeta pública

User-agent: *

Disallow: /imagenes/

Allow: /imagenes/publicas/# Incluir sitemap

User-agent: *

Disallow: /tmp/

Sitemap: https://tu-sitio.com/sitemap.xml# Restringir el acceso a contenido sensible de staging o pruebas

User-agent: *

Disallow: /staging/# Permitir bots de medios pero bloquear otros

User-agent: *

Disallow: /

User-agent: Googlebot-Image

Disallow:

User-agent: Googlebot-News

Disallow:# Bloquear páginas con ciertas extensiones dinámicas

User-agent: *

Disallow: /*.cgi$# Bloquear carpetas duplicadas por idioma

User-agent: *

Disallow: /en/

Disallow: /fr/# Evitar el rastreo de enlaces de afiliación

User-agent: *

Disallow: /afiliados/# Bloquear plugins de WordPress

User-agent: *

Disallow: /wp-content/plugins/LIMITACIONES DEL ROBOTS.TXT

Aunque el archivo robots.txt es una herramienta muy útil para gestionar el rastreo de tu sitio, no es infalible ni está pensado como una solución definitiva. Tiene varias limitaciones que debes tener muy en cuenta para evitar malentendidos o errores en tu estrategia SEO:

- No garantiza privacidad. Cualquier usuario puede acceder al archivo robots.txt simplemente escribiendo la URL en su navegador. Si estás intentando ocultar información sensible, esta no es la herramienta adecuada. Usa protección por contraseña o autenticación para contenido verdaderamente privado.

- Bots maliciosos lo ignoran. Muchos rastreadores respetables siguen las reglas del robots.txt, pero los bots maliciosos pueden desobedecerlas por completo. No confíes en este archivo como medida de seguridad.

- El URL bloqueado puede seguir apareciendo en Google. Aunque una página esté bloqueada para el rastreo, si otras webs enlazan a ella, Google puede mostrarla en los resultados con solo su URL. Para evitar esto, es mejor combinar robots.txt con etiquetas noindex o bloqueos por HTTP.

- Diferentes bots interpretan reglas de distinto modo. No todos los bots procesan el archivo de la misma manera. Algunos pueden ignorar ciertas directivas o tener comportamientos impredecibles. Por eso, siempre es recomendable testear con diferentes herramientas.

PREGUNTAS FRECUENTES

¿EL ARCHIVO ROBOTS.TXT PROTEGE CONTENIDO PRIVADO?

No. Cualquiera puede acceder al archivo y algunos bots maliciosos lo ignoran. Si necesitas privacidad, usa autenticación o bloqueo por contraseña.

¿PUEDO USAR ROBOTS.TXT PARA EVITAR QUE UNA PÁGINA APAREZCA EN GOOGLE?

No del todo. Si otros sitios enlazan a esa página, Google puede mostrar la URL aunque no la rastree. Para evitar su indexación, usa noindex en el HTML.

¿DÓNDE DEBO SUBIR EL ARCHIVO ROBOTS.TXT?

Debe estar ubicado en la raíz del dominio, accesible desde https://tusitio.com/robots.txt.

¿CÓMO PRUEBO SI MI ARCHIVO ROBOTS.TXT ESTÁ BIEN CONFIGURADO?

Puedes usar la herramienta “Probador de robots.txt” en Google Search Console para verificar que tus reglas se interpreten correctamente.

¿QUÉ PASA SI ME EQUIVOCO EN LA SINTAXIS?

Una mala sintaxis puede bloquear secciones importantes de tu web o dejar contenido expuesto sin querer. Por eso es crucial revisarlo bien y testearlo.

¿CÓMO OPTIMIZA EL SEO UN ARCHIVO ROBOTS.TXT BIEN HECHO?

Permite que los bots se enfoquen en las páginas importantes, evita contenido duplicado y reduce la carga innecesaria en tu servidor. Es clave para optimizar el presupuesto de rastreo.

¿CUÁNTOS ROBOTS.TXT PUEDO TENER EN MI WEB?

Solo uno por dominio. No se admiten múltiples archivos robots.txt.

¿PUEDO INCLUIR MI SITEMAP EN EL ROBOTS.TXT?

Sí, y es una práctica recomendada. Puedes añadir una línea como:

Sitemap: https://tusitio.com/sitemap.xml

CONCLUSIÓN

Configurar bien un robots.txt es una de esas tareas que parecen pequeñas, pero que tienen un gran impacto. Este archivo define cómo los motores de búsqueda interactúan con tu web y, si se hace mal, puede bloquear contenido valioso o permitir el rastreo de páginas que deberían mantenerse ocultas. Es el primer filtro entre tu sitio y los bots, y por tanto, es clave en cualquier estrategia SEO bien pensada.

No basta con tenerlo: hay que entenderlo, testearlo y revisarlo periódicamente. A medida que tu web crece o cambia, también deben ajustarse las reglas del robots.txt para reflejar su nueva estructura o prioridades. Y recuerda: no es una herramienta de seguridad, sino de gestión de visibilidad.

Dedica unos minutos a entender tu robots.txt y estarás evitando dolores de cabeza en el futuro. Un archivo bien hecho marca la diferencia entre un SEO optimizado y uno que rema contracorriente.

Nos vamos viendo.

GUÍA PARA AUDITORÍA SEO BÁSICA EN WORDPRESS

«Obtén gratis la guía paso a paso para detectar errores SEO en tu WordPress y mejora tu posicionamiento en Google»

Quiero mi GuíaÓscar Bages

¡Hola! Soy Óscar Bages, un apasionado del mundo digital, especializado en Posicionamiento SEO y en la creación de Tiendas Online. Con más de una década de experiencia, me gustaría transmitir parte de mi conocimiento, para todo aquél que quiera aprovecharlo. Nos vamos viendo...